NVIDIA là một trong những công ty dẫn đầu trong lĩnh vực siêu máy tính và phần cứng AI với các sản phẩm và nền tảng được thiết kế để đáp ứng nhu cầu tính toán chuyên sâu. Bài viết sẽ cung cấp các thông tin tổng quan về siêu máy tính và phần cứng AI của NVIDIA.

1. Siêu máy tính AI của NVIDIA là gì?

Siêu máy tính AI của NVIDIA là các hệ thống cực lớn chứa hàng trăm nghìn GPU vốn rất phù hợp cho các tác vụ tính toán song song trong đào tạo AI, khác với siêu máy tính truyền thống sử dụng nhiều CPU. Khách hàng chính là các công ty công nghệ lớn như Microsoft, Google, Amazon,…

Một số nền tảng siêu máy tính nổi bật của NVIDIA có thể kể đến là:

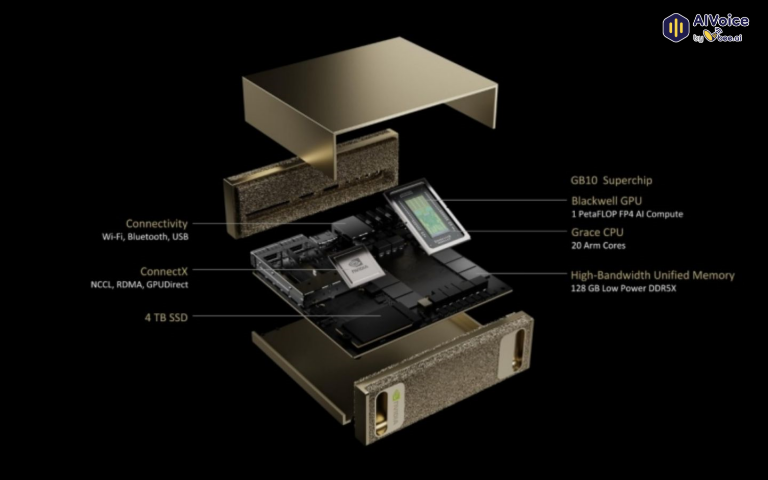

- Project Digits: Siêu máy tính AI cá nhân nhỏ nhất thế giới, giá khoảng 3.000 USD, sử dụng siêu chip GB10 Grace Blackwell, kết hợp CPU Grace dựa trên kiến trúc ARM. Nó cung cấp hiệu suất lên đến 1 petaflop và có thể xử lý các mô hình AI với tối đa 200 tỷ tham số. Project Digits phù hợp cho nhà nghiên cứu AI, nhà khoa học dữ liệu, sinh viên và người dùng cá nhân muốn phát triển và chạy mô hình AI tại chỗ.

- NVIDIA DGX Station: Máy trạm AI chuyên dụng trang bị chip GB300 Grace Blackwell Ultra gồm CPU 72 lõi và GPU Blackwell Ultra thế hệ mới, cùng công nghệ NVLink-C2C để chia sẻ bộ nhớ đồng nhất giữa CPU và GPU. Đây là hệ thống mạnh mẽ chủ yếu phục vụ các nhóm nghiên cứu và doanh nghiệp vừa.

- NVIDIA HGX: Nền tảng siêu máy tính tập trung cho điện toán AI và HPC, tích hợp nhiều GPU NVIDIA (như A100, H100, H200) kết nối qua công nghệ NVLink và NVSwitch, tối ưu băng thông và giảm độ trễ trong xử lý song song trên quy mô lớn. HGX được tích hợp vào các hệ thống máy chủ của các hãng tên tuổi như Dell, Supermicro, HPE, v.v..

- Jetson Orin Nano Super: Nền tảng siêu máy tính AI siêu nhỏ gọn, có công suất lên đến 68 nghìn tỷ phép tính mỗi giây, thích hợp cho các mô hình AI tạo sinh, có giá bán rẻ khoảng 249 USD, dễ tiếp cận các nhà phát triển AI ở cấp độ thiết bị nhỏ.

Những nền tảng này thể hiện chiến lược của NVIDIA trong việc cung cấp giải pháp đa dạng từ siêu máy tính AI quy mô lớn cho trung tâm dữ liệu đến các thiết bị cá nhân và nhúng, đều tập trung tối ưu cho các tác vụ và mô hình AI hiện đại.

2. Phần cứng AI của NVIDIA

NVIDIA không chỉ dẫn đầu về phần mềm AI mà còn sở hữu hệ sinh thái phần cứng mạnh mẽ, từ chip xử lý đến kiến trúc kết nối và mạng tốc độ cao. Những nền tảng phần cứng dưới đây đang đóng vai trò trung tâm trong các hệ thống AI hiện đại.

2.1 Grace Blackwell Superchip (GB10 và GB200)

GB10 là dòng Superchip nhỏ gọn, tích hợp GPU Blackwell với Tensor Core thế hệ thứ 5 và CPU Grace 20 nhân (kiến trúc Arm). Với hiệu suất đạt tới 1 petaFLOP ở độ chính xác FP4 và 128GB bộ nhớ LPDDR5x, GB10 phù hợp cho các hệ thống AI cá nhân như NVIDIA DGX Spark, cho phép đào tạo mô hình lên đến hàng trăm tỷ tham số ngay trên desktop.

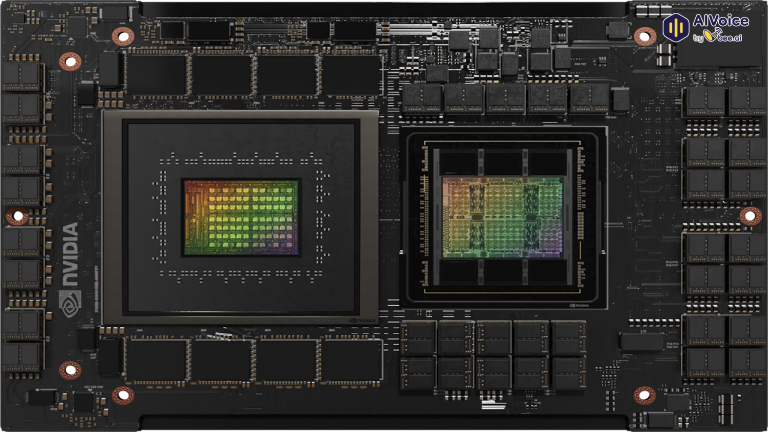

GB200 là phiên bản cao cấp hơn, được thiết kế cho trung tâm dữ liệu và siêu máy tính quy mô lớn. Nó kết hợp 2 GPU Blackwell và 2 CPU Grace, kết nối trực tiếp bằng công nghệ NVLink-C2C. GB200 là nền tảng của các hệ thống như NVIDIA DGX GB200 NVL72 và siêu máy tính Isambard-AI, mang lại hiệu suất vượt trội cho tác vụ AI Exascale.

2.2 Grace CPU Superchip

Được phát triển dựa trên kiến trúc Arm Neoverse, CPU Grace được tối ưu hóa cho hiệu suất năng lượng trong các ứng dụng AI và HPC. Nó được triển khai trong các siêu máy tính như Venado tại Los Alamos National Laboratory, nơi toàn bộ hệ thống (kết hợp cả GPU và CPU) có thể đạt hiệu suất lên tới 10 exaFLOP ở độ chính xác FP8.

2.3 Hopper Architecture: GPU H100 và H200

GPU dòng Hopper của NVIDIA là nền tảng chủ lực cho cả đào tạo (training) và suy luận (inference) AI:

- H100: Tối ưu cho huấn luyện mô hình lớn, được sử dụng trong nhiều trung tâm dữ liệu AI.

- H200: Hỗ trợ bộ nhớ HBM3e tốc độ cao, lý tưởng cho các tác vụ suy luận nặng về dữ liệu.

Một ví dụ điển hình là Colossus, siêu máy tính của xAI (Elon Musk), hiện đang vận hành hàng trăm ngàn GPU H100 để đào tạo các mô hình ngôn ngữ quy mô cực lớn.

2.4 Kết nối tốc độ cao: NVLink-C2C và ConnectX SuperNIC

NVLink-C2C là công nghệ kết nối trực tiếp giữa CPU và GPU với băng thông lên tới 900GB/s, giúp giảm độ trễ và tăng hiệu suất xử lý AI.

ConnectX-7 và ConnectX-8 SuperNIC (thuộc dòng sản phẩm của Mellanox – công ty con của NVIDIA) hỗ trợ kết nối mạng lên tới 800Gb/s, đảm bảo truyền tải dữ liệu tốc độ cao trong hệ thống AI và siêu máy tính hiện đại.

3. Ứng dụng và tác động

Các siêu máy tính và phần cứng AI của NVIDIA được sử dụng trong nhiều lĩnh vực như nghiên cứu khoa học (dự báo thời tiết, phát triển dược phẩm), robot, thị giác máy tính và mô hình ngôn ngữ lớn (LLM). Chúng hỗ trợ các mô hình như OpenReasoning-Nemotron, GR00T, Cosmos Reason.

Các hệ thống như Grace CPU và Blackwell được thiết kế để cải thiện hiệu suất năng lượng. Ví dụ tăng hiệu quả năng lượng gấp 5 lần so với các node CPU trên siêu máy tính Perlmutter.

NVIDIA đang đầu tư 500 tỷ USD trong 4 năm để sản xuất siêu máy tính AI tại Mỹ, hợp tác với TSMC, Foxconn, Wistron, Amkor, SPIL nhằm tăng cường chuỗi cung ứng và tạo hàng trăm ngàn việc làm.

4. Tương lai của phần cứng AI và siêu máy tính NVIDIA

NVIDIA đang dẫn đầu cuộc đua tiến đến AI Exascale – cột mốc mà tại đó các hệ thống AI có thể xử lý hơn 1 exaFLOP dành riêng cho tác vụ trí tuệ nhân tạo. Đây không chỉ là bước nhảy về hiệu suất, mà còn là chìa khóa để hiện thực hóa các mô hình ngôn ngữ đa mô thức khổng lồ như GPT-5, Gemini Ultra hay Grok.

Thay vì tách biệt các tầng tính toán như trước, NVIDIA đang thúc đẩy xu hướng kiến trúc hội tụ, nơi AI có thể vận hành liền mạch từ trung tâm dữ liệu, đám mây đến thiết bị biên. Các dòng chip như Grace Hopper Superchip (GH200) hay Jetson Orin Nano được thiết kế để đáp ứng khả năng xử lý mạnh mẽ, nhưng vẫn đủ linh hoạt để hoạt động trong môi trường giới hạn tài nguyên.

Trong bối cảnh các mô hình AI ngày càng lớn, việc tối ưu hiệu suất trên mỗi watt trở thành ưu tiên hàng đầu. NVIDIA đang thiết kế các kiến trúc phần cứng giúp tiết kiệm năng lượng gấp nhiều lần so với thế hệ cũ, đồng thời tích hợp khả năng AI trực tiếp trên die (như NPU, DPU, AI Engine). Ngoài ra, xu hướng thiết kế mô-đun giúp doanh nghiệp mở rộng hệ thống dễ dàng, thay vì phải thay toàn bộ phần cứng.

5. Các câu hỏi thường gặp

5.1 NVIDIA có phải là nhà sản xuất siêu máy tính không?

NVIDIA không trực tiếp sản xuất toàn bộ hệ thống siêu máy tính nhưng họ cung cấp các nền tảng phần cứng cốt lõi như GPU, CPU và công nghệ kết nối – trái tim của các siêu máy tính AI hiện đại. Họ cũng hợp tác với các đối tác như HPE, Dell, Supermicro… để xây dựng hệ thống hoàn chỉnh.

5.2 Siêu máy tính AI của NVIDIA khác gì với siêu máy tính truyền thống?

Siêu máy tính truyền thống chủ yếu dựa trên CPU để xử lý mô phỏng vật lý, mô hình thời tiết… Trong khi đó, siêu máy tính AI của NVIDIA sử dụng GPU chuyên dụng (như H100, Blackwell) để xử lý hàng triệu phép toán song song, rất phù hợp cho đào tạo và suy luận các mô hình AI lớn.

5.3 Tôi có thể sử dụng phần cứng của NVIDIA cho dự án AI cá nhân không?

Hoàn toàn có thể. NVIDIA cung cấp hệ sinh thái phần cứng, phần mềm, tài liệu, SDK (như CUDA, TensorRT, cuDNN) để người dùng ở mọi cấp độ có thể triển khai các dự án AI, từ xử lý ảnh, âm thanh đến huấn luyện mô hình ngôn ngữ lớn.

5.4 Tại sao các công ty như Microsoft, Google lại sử dụng phần cứng của NVIDIA?

Vì NVIDIA hiện là nhà cung cấp GPU AI mạnh nhất thế giới, với hiệu năng vượt trội, cộng đồng phát triển lớn, và khả năng mở rộng quy mô cực kỳ linh hoạt. Các tập đoàn lớn cần phần cứng mạnh mẽ để huấn luyện và vận hành các mô hình AI thế hệ mới, điều mà NVIDIA đang làm tốt nhất.

5.5 NVIDIA đang đầu tư bao nhiêu vào lĩnh vực siêu máy tính AI?

NVIDIA đã công bố kế hoạch đầu tư khoảng 500 tỷ USD trong 4 năm để xây dựng và mở rộng chuỗi cung ứng siêu máy tính AI tại Mỹ, hợp tác với các đối tác như TSMC, Foxconn, Amkor…, tạo hàng trăm nghìn việc làm công nghệ cao.

Như vậy, bài viết trên đã cung cấp các thông tin về siêu máy tính và phần cứng AI của NVIDIA. NVIDIA không chỉ dẫn đầu về GPU mà còn đóng vai trò định hình hạ tầng AI toàn cầu. Việc hiểu rõ phần cứng phía sau các mô hình AI sẽ giúp khai thác tối đa sức mạnh tính toán, mở ra nhiều cơ hội đổi mới. Hy vọng bài viết đã giúp bạn có cái nhìn rõ hơn về vai trò của NVIDIA trong hệ sinh thái AI hiện đại.