Trong bài viết này, chúng ta sẽ tìm hiểu ảo giác AI là gì, vì sao hiện tượng này xảy ra và những cách giúp kiểm soát AI chính xác hơn trong quá trình sử dụng.

1. AI hallucination là gì?

AI hallucination hay ảo giác AI, đây là hiện tượng khi trí tuệ nhân tạo tạo ra thông tin sai lệch, không có thật hoặc khác hoàn toàn với dữ liệu thực tế. Nói cách đơn giản, đây là lúc AI “tưởng tượng” ra dữ liệu hoặc câu trả lời mà nó cho là đúng, nhưng trên thực tế lại không tồn tại hoặc không chính xác.

Hiện tượng này thường gặp ở các mô hình ngôn ngữ lớn (LLM) như ChatGPT, Bard hay Claude. Khi người dùng đặt câu hỏi, đôi khi AI phản hồi rất tự tin, mạch lạc nhưng nội dung đó có thể hoàn toàn sai. Tình huống này tương tự như việc con người “nhìn thấy ảo giác” về những thứ không có thật.

2. Các loại ảo giác AI thường gặp

2.1 Sai lệch thực tế

Sai lệch thực tế là dạng ảo giác AI phổ biến nhất. Đây là hiện tượng khi mô hình AI đưa ra thông tin trái ngược với kiến thức khách quan, ví dụ như: “Paris là thủ đô của Ý”, “nước đóng băng ở 25°C”, hay “con người có ba lá phổi”.

Trong các lĩnh vực quan trọng như y tế, kiểu sai lệch này có thể dẫn đến hậu quả nghiêm trọng, chẳng hạn AI đưa ra chẩn đoán không đúng hoặc gợi ý liều thuốc sai. Tương tự, trong tài chính, AI có thể cung cấp thông tin không chính xác về lãi suất hoặc xu hướng đầu tư, làm ảnh hưởng đến quyết định của người dùng.

2.2 Nội dung bịa đặt

Nội dung bịa đặt xảy ra khi AI tự tạo ra các thông tin chưa từng tồn tại, chẳng hạn:

- Trích dẫn nghiên cứu khoa học không có thật.

- Đưa ra các sự kiện lịch sử “tự tưởng tượng”.

- Liệt kê sách, phim, bài báo không hề tồn tại.

Hiện tượng này thường xuất hiện khi AI gặp câu hỏi vượt ngoài hiểu biết hoặc nằm ngoài dữ liệu huấn luyện. Thay vì trả lời “Tôi không biết”, mô hình lại cố gắng ghép nối các thông tin rời rạc để tạo ra câu trả lời… nghe có vẻ hợp lý nhưng hoàn toàn bịa đặt.

2.3 Câu trả lời vô nghĩa

Câu trả lời vô nghĩa là khi AI đưa ra nội dung không liên quan, không logic hoặc hoàn toàn không hiểu được. Khác với sai lệch thông tin, lỗi này khiến câu trả lời của AI trở nên rời rạc, thiếu mạch lạc hoặc thậm chí… kỳ quặc.

Ví dụ, khi hỏi “cách làm bánh mì”, AI lại trả lời về “lịch sử ngành xe hơi”, hoặc tạo ra câu nói không hề có ý nghĩa như: “bánh mì được tạo từ không gian mỏng giữa các phân tử nước nén lại bởi áp suất”.

Loại ảo giác này thường xuất hiện khi AI gặp:

- Câu hỏi quá mơ hồ.

- Thông tin đầu vào khó hiểu.

- Lỗi trong quá trình xử lý ngôn ngữ.

3. Nguyên nhân gây ra ảo giác AI

3.1 Thiếu hụt dữ liệu

Một trong những nguyên nhân phổ biến nhất gây ra Ảo giác AI là dữ liệu huấn luyện không đủ hoặc thiếu tính đa dạng. Khi mô hình không được học đủ thông tin về một chủ đề, nó sẽ phải tự suy đoán dựa trên những dữ liệu ít ỏi mà nó có.

Chẳng hạn, một mô hình chủ yếu được đào tạo từ dữ liệu Bắc Mỹ có thể đưa ra nhận định sai về văn hóa hoặc luật pháp của các khu vực khác. Tương tự, nếu dữ liệu huấn luyện chỉ kéo dài đến năm 2021, AI sẽ không biết về các sự kiện quan trọng xảy ra sau thời điểm đó.

Trong lĩnh vực y tế, sự thiếu hụt dữ liệu có thể dẫn đến chẩn đoán sai. Ví dụ một mô hình được huấn luyện chủ yếu trên dữ liệu bệnh nhân nam có thể không đưa ra kết quả chính xác cho bệnh nhân nữ. Vì vậy, đa dạng hóa dữ liệu là yếu tố then chốt để giảm thiểu nguy cơ ảo giác.

3.2 Hiện tượng quá khớp

Quá khớp xảy ra khi mô hình học quá kỹ dữ liệu huấn luyện, đến mức bao gồm cả những yếu tố không đại diện cho thực tế. Điều này khiến mô hình trả lời tốt với dữ liệu quen thuộc nhưng bối rối khi gặp tình huống mới, từ đó sinh ra ảo giác.

Ví dụ, nếu hầu hết câu hỏi về Việt Nam trong dữ liệu huấn luyện liên quan đến ẩm thực, mô hình có thể “ngầm hiểu” rằng Việt Nam chỉ nổi bật về ẩm thực. Khi được hỏi về lịch sử, nó có thể cố liên hệ thông tin về đồ ăn và tạo ra câu trả lời sai.

Quá khớp thường xuất hiện khi mô hình quá phức tạp so với dữ liệu hoặc khi dữ liệu chứa nhiều nhiễu. Đây là lý do tại sao việc cân bằng kích thước mô hình và chất lượng dữ liệu là điều cực kỳ quan trọng.

3.3 Kiến trúc mô hình không phù hợp

Mỗi loại mô hình AI (Transformers, RNN, CNN…) đều được thiết kế cho những nhiệm vụ riêng. Khi lựa chọn sai kiến trúc cho bài toán, AI có thể xử lý thông tin không chính xác và tạo ra câu trả lời ảo.

Ví dụ:

- Mô hình chuyên xử lý hình ảnh sẽ gặp khó khi xử lý câu hỏi văn bản phức tạp.

- Mô hình nhỏ không đủ khả năng hiểu các mối quan hệ phức tạp trong dữ liệu.

- Mô hình quá lớn lại dễ gặp hiện tượng quá khớp.

3.4 Phương pháp tạo nội dung

Cách AI tạo ra câu trả lời cũng là yếu tố trực tiếp dẫn đến ảo giác. Đối với các mô hình ngôn ngữ lớn, chúng hoạt động bằng cách dự đoán từ tiếp theo trong câu dựa trên ngữ cảnh trước đó. Tuy nhiên, quá trình này không có bước kiểm chứng thông tin, khiến mô hình dễ tạo ra câu văn mạch lạc nhưng sai sự thật.

Ví dụ, khi được yêu cầu mô tả một nhân vật lịch sử, AI có thể “nhớ mang máng” vài chi tiết và ghép chúng lại với nhau, tạo ra thông tin nghe có vẻ hợp lý nhưng hoàn toàn không chính xác.

4. Tác động của Ảo giác AI

4.1 Rủi ro an ninh

Ảo giác AI có thể tạo ra những nguy cơ an ninh nghiêm trọng, đặc biệt khi hệ thống được tích hợp vào các nền tảng nhạy cảm. Trong lĩnh vực an ninh mạng, một thông tin sai có thể dẫn đến việc bỏ sót một mối đe dọa thực sự… hoặc kích hoạt cảnh báo giả khiến doanh nghiệp phản ứng sai hướng.

Ở quốc phòng, các hệ thống sử dụng AI để đánh giá rủi ro hoặc hỗ trợ ra quyết định có thể hiểu sai dữ liệu và đưa ra nhận định lệch lạc. Trong bối cảnh khẩn cấp, một đánh giá sai có thể dẫn đến phản ứng không phù hợp và gây hậu quả khó lường.

Đáng chú ý hơn, tội phạm mạng có thể khai thác ảo giác AI để trích xuất dữ liệu nhạy cảm thông qua các kỹ thuật như prompt injection (Tiêm mã nhanh để thao túng đầu ra của LLM). Điều này có thể khiến hệ thống AI vô tình tiết lộ thông tin bí mật, tài liệu nội bộ hoặc dữ liệu khách hàng.

4.2 Thiệt hại kinh tế và mất uy tín

Ảo giác AI không chỉ gây sai lệch thông tin mà còn có thể mang đến tổn thất tài chính lớn. Khi doanh nghiệp dựa vào AI để dự báo, phân tích xu hướng hoặc hỗ trợ quyết định đầu tư, những sai lệch do AI tạo ra có thể dẫn đến quyết định không chính xác.

Một doanh nghiệp có thể đầu tư mạnh vào một dự án dựa trên phân tích từ AI chỉ để phát hiện rằng những kết luận đó được tạo ra từ dữ liệu lỗi hoặc suy luận sai. Hậu quả không chỉ là thiệt hại tài chính mà còn khiến cổ đông, đối tác và khách hàng mất lòng tin.

Trong một số trường hợp, khi doanh nghiệp vô tình công bố thông tin sai do AI cung cấp, họ có thể phải đối mặt với khủng hoảng truyền thông, buộc phải xin lỗi hoặc đính chính công khai.

4.3 Lan truyền thông tin sai lệch

Ảo giác AI góp phần làm gia tăng tốc độ lan truyền tin giả trên Internet. Người dùng thường tin tưởng vào câu trả lời từ chatbot hoặc trợ lý ảo. Nếu AI trả lời sai, những thông tin đó có thể bị chia sẻ rộng rãi trên mạng xã hội trước khi ai đó kịp kiểm chứng.

Đặc biệt trong thời đại mạng xã hội, chỉ một thông tin sai do AI tạo ra cũng có thể:

- Lan truyền hàng nghìn lần chỉ trong vài giờ.

- Gây hiểu nhầm trong cộng đồng.

- Tác động đến quan điểm chính trị, sức khỏe, tài chính.

Trong lĩnh vực y tế, một lời khuyên sai có thể đe dọa sức khỏe cộng đồng. Trong chính trị, thông tin giả có thể làm chia rẽ dư luận và gây bất ổn xã hội.

4.5 Xói mòn niềm tin

Một trong những tác động nghiêm trọng nhất của Ảo giác AI là làm giảm niềm tin của xã hội đối với công nghệ AI. Khi người dùng liên tục gặp phải thông tin sai, họ sẽ dần nghi ngờ độ chính xác của hệ thống.

Nếu điều này kéo dài, nó có thể tạo ra:

- “Mệt mỏi vì AI” – người dùng từ chối sử dụng công cụ AI.

- Sự hoài nghi về hiệu quả và tính minh bạch của các công nghệ mới.

- Tâm lý e ngại của doanh nghiệp khi đầu tư vào giải pháp AI.

- Yêu cầu siết chặt các quy định và chính sách quản lý AI.

5. Một số nguyên tắc khi đặt prompt tránh “Ảo giác”

Ảo giác AI là hiện tượng khó tránh hoàn toàn, nhưng bạn có thể chủ động giảm thiểu bằng cách xây dựng prompt đúng hướng. Khi câu lệnh rõ ràng, có bối cảnh và giới hạn phạm vi, AI sẽ ít “bịa” hơn và đưa ra câu trả lời chính xác hơn. Dưới đây là bộ nguyên tắc quan trọng giúp bạn kiểm soát chất lượng đầu ra hiệu quả.

5.1 Cung cấp ngữ cảnh cụ thể

Khi prompt quá chung chung, AI dễ suy đoán và tạo thông tin sai. Việc thêm bối cảnh sẽ giúp câu trả lời chính xác hơn.

Ví dụ cải thiện:

Thay vì viết “Giải thích về du lịch”, hãy đặt lại thành: “Tóm tắt xu hướng du lịch Nhật Bản của du khách Việt Nam trong giai đoạn 2022–2024 dựa trên số liệu thống kê chính thức.”

5.2 Yêu cầu AI dựa trên dữ liệu đã được xác minh

Nếu không giới hạn, AI có thể tự tạo thông tin nghe có vẻ hợp lý nhưng thực tế không tồn tại. Hãy yêu cầu rõ ràng rằng câu trả lời phải dựa trên nguồn được công nhận.

Ví dụ cải thiện:

Thay vì hỏi “Có những phương pháp điều trị ung thư nào?”, hãy chuyển thành: “Những phương pháp điều trị ung thư được FDA phê duyệt đến năm 2025 là gì? Nếu thiếu dữ liệu, hãy nêu rõ.”

5.3 Sử dụng câu hỏi đóng hoặc câu hỏi có giới hạn

Câu hỏi rộng khiến AI dễ suy diễn. Đặt câu hỏi với phạm vi nhỏ sẽ giúp AI trả lời đúng trọng tâm.

Ví dụ cải thiện:

Thay vì hỏi “Giáo dục Việt Nam sẽ thay đổi thế nào?”, hãy đặt thành: “Chương trình giáo dục phổ thông mới có khả năng áp dụng trên toàn quốc trước năm 2027 không?”

5.4 Tránh yêu cầu AI dự đoán xa tương lai

AI không có khả năng nhìn trước tương lai. Hãy yêu cầu AI dựa trên dữ liệu hoặc mô hình đã công bố.

Ví dụ cải thiện:

Thay vì hỏi “Thị trường xe điện toàn cầu sẽ ra sao vào năm 2070?”, hãy dùng: “Dựa trên báo cáo thị trường năm 2023, xu hướng tăng trưởng xe điện trong 5 năm tới là gì?”

5.5 Yêu cầu AI tự kiểm tra hoặc giải thích nguồn

Điều này giúp hạn chế thông tin bịa đặt và tăng độ tin cậy.

Ví dụ cải thiện:

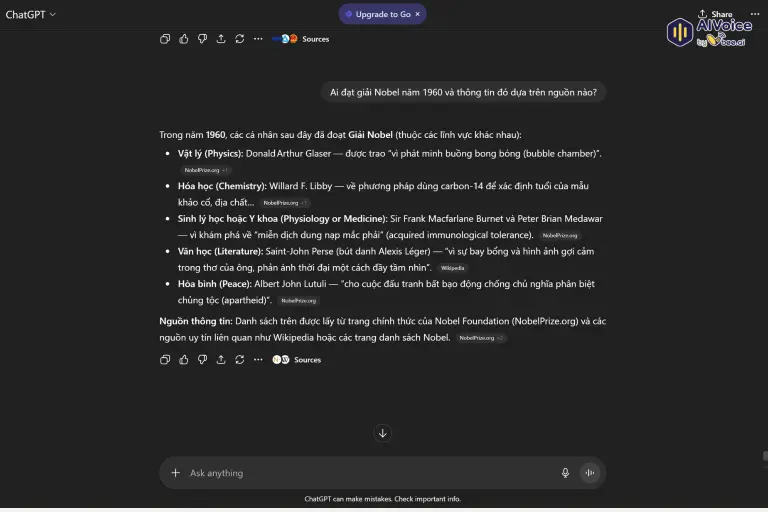

Thay vì hỏi “Ai đạt giải Nobel năm 1960?”, hãy đặt thành: “Ai đạt giải Nobel năm 1960 và thông tin đó dựa trên nguồn nào?”

5.6 Giới hạn mức độ sáng tạo khi cần tính chính xác

Một số yêu cầu cần thông tin khách quan, không phải diễn giải hay tưởng tượng.

Ví dụ cải thiện:

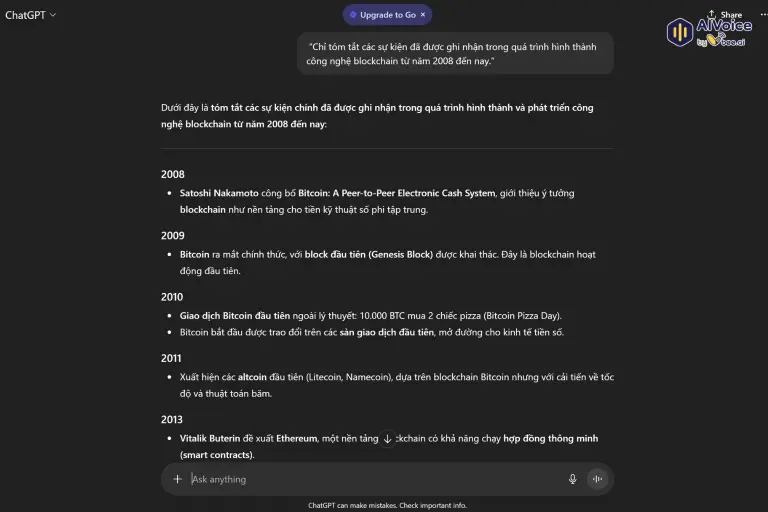

Thay vì yêu cầu “Kể về lịch sử blockchain”, hãy dùng: “Chỉ tóm tắt các sự kiện đã được ghi nhận trong quá trình hình thành công nghệ blockchain từ năm 2008 đến nay.”

5.7 Chia nhỏ yêu cầu thành nhiều bước

Prompt quá rộng khiến AI đưa ra câu trả lời thiếu liên kết. Hãy tách thành từng phần nhỏ.

Ví dụ cải thiện:

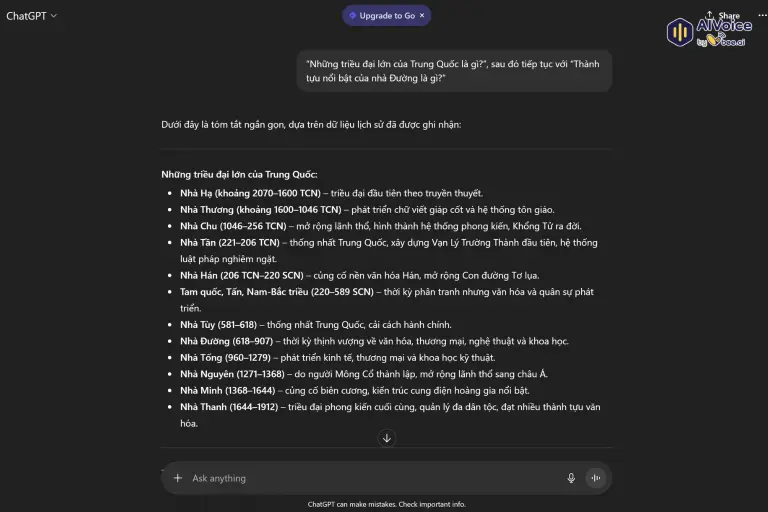

Thay vì nói “Nói về lịch sử Trung Quốc”, hãy chia thành: “Những triều đại lớn của Trung Quốc là gì?”, sau đó tiếp tục với “Thành tựu nổi bật của nhà Đường là gì?”

5.8 Dùng chỉ thị rõ ràng để định hướng phản hồi

Các yêu cầu mang tính chỉ thị mạnh giúp AI tránh đưa thêm chi tiết không xác thực.

Ví dụ cải thiện:

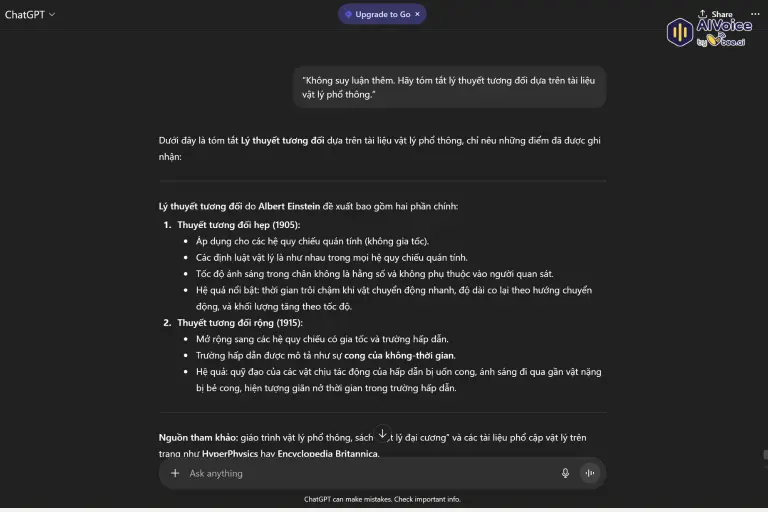

Thay vì yêu cầu “Tóm tắt lý thuyết tương đối”, hãy viết: “Không suy luận thêm. Hãy tóm tắt lý thuyết tương đối dựa trên tài liệu vật lý phổ thông.”

5.9 Kiểm tra chéo thông tin ngay trong hội thoại

Sau khi AI trả lời, bạn có thể đặt câu hỏi tiếp theo để xác nhận độ chính xác.

Ví dụ cải thiện:

Hãy hỏi: “Con số này được trích từ nguồn nào? Có thể đối chiếu với thêm một nguồn khác không?”

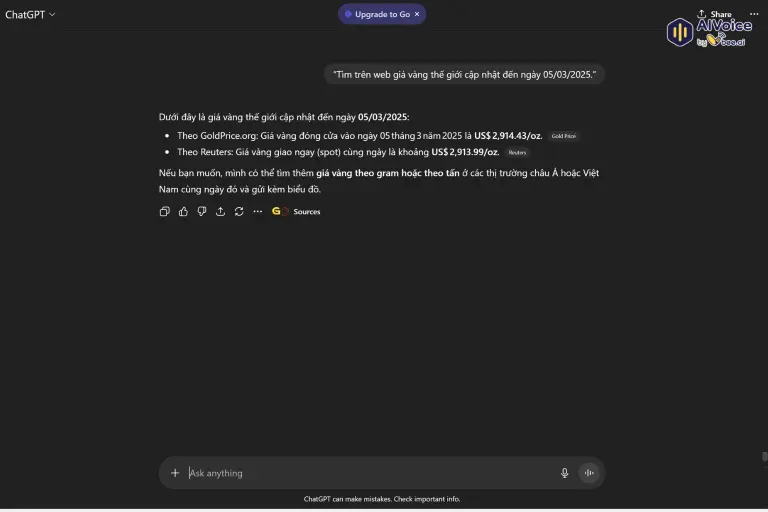

5.10 Yêu cầu cập nhật thông tin mới nhất

Với các mô hình có thể tìm kiếm web, hãy yêu cầu thông tin cập nhật theo thời điểm cụ thể.

Ví dụ cải thiện:

Thay vì hỏi “Giá vàng hôm nay thế nào?”, hãy yêu cầu: “Tìm trên web giá vàng thế giới cập nhật đến ngày 05/03/2025.”

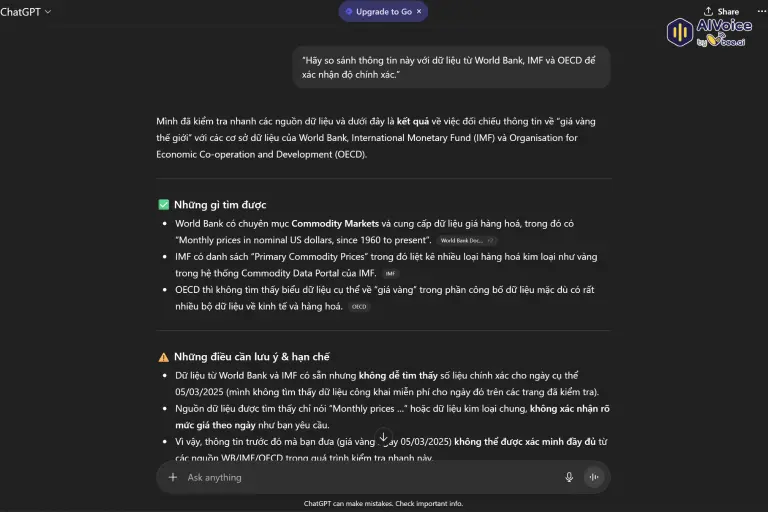

5.11 Kiểm chứng từ nhiều nguồn

Không nên phụ thuộc vào một câu trả lời duy nhất. Hãy yêu cầu AI đối chiếu với dữ liệu từ vài nguồn uy tín khác.

Ví dụ cải thiện:

“Hãy so sánh thông tin này với dữ liệu từ World Bank, IMF và OECD để xác nhận độ chính xác.”

6. Những câu hỏi thường gặp về AI Hallucination (Ảo giác AI)

6.1 AI Hallucination có xảy ra ở mọi mô hình AI không?

Có. Bất kỳ mô hình AI nào sử dụng dữ liệu huấn luyện để dự đoán, đặc biệt là mô hình ngôn ngữ lớn, đều có nguy cơ tạo ra ảo giác AI. Mức độ khác nhau tùy theo chất lượng dữ liệu và kiến trúc mô hình.

6.2 Làm sao biết AI đang “bịa” thông tin?

Bạn có thể nhận biết qua các dấu hiệu như: thông tin nghe có vẻ hợp lý nhưng không thể kiểm chứng, số liệu tròn trịa bất thường, viện dẫn nguồn không tồn tại hoặc mô tả sự kiện mà không có bằng chứng rõ ràng.

6.3 Liệu dùng phiên bản AI trả phí có giảm ảo giác so với bản miễn phí?

Thông thường, các mô hình trả phí được huấn luyện tốt hơn, cập nhật thường xuyên và có khả năng xử lý ngữ cảnh sâu hơn, vì vậy tỷ lệ ảo giác thường thấp hơn. Tuy nhiên, không mô hình nào có thể loại bỏ hoàn toàn hiện tượng này.

6.4 Tôi có thể phát hiện ảo giác AI bằng cách nào?

Bạn có thể kiểm tra qua ba bước: đối chiếu nguồn, tìm bằng chứng từ các tài liệu chính thống và yêu cầu AI giải thích logic đằng sau câu trả lời. Nếu AI không giải thích được, đó là tín hiệu cảnh báo.

Hy vọng bài viết trên đã giúp bạn đọc hiểu rõ hơn về AI Hallucination, lý do xuất hiện ảo giác AI và cách hạn chế chúng khi làm việc với các mô hình trí tuệ nhân tạo. Nắm vững những nguyên tắc này sẽ giúp bạn sử dụng AI an toàn, chính xác và hiệu quả hơn trong mọi tác vụ.