Bài viết sau đây sẽ giúp bạn hiểu rõ hơn về Tensor Core là gì, cách chúng hoạt động và các ứng dụng trong thực tế của chúng như thế nào.

1. Tensor Core là gì?

Tensor là một cấu trúc dữ liệu đa chiều, tương tự như ma trận nhưng có thể mở rộng đến nhiều chiều hơn. Đây là cách phổ biến để biểu diễn và xử lý dữ liệu như hình ảnh, âm thanh, văn bản… trong các mô hình học máy và trí tuệ nhân tạo.

Tensor Core (hay Lõi Tensor) là một loại lõi xử lý chuyên dụng trên các GPU của NVIDIA, được thiết kế đặc biệt để tăng tốc đáng kể các phép tính phức tạp trong lĩnh vực học máy và trí tuệ nhân tạo. Với kiến trúc độc đáo, chúng đủ mạnh để tăng hiệu suất tổng thể trong khi vẫn duy trì độ chính xác. Thế hệ Tensor Core đầu tiên đã tạo ra bước đột phá bằng cách hợp nhất các phép nhân và cộng ma trận 4×4 FP16 thành ma trận 4×4 FP16 hoặc FP32.

2. Tensor Core hoạt động như thế nào?

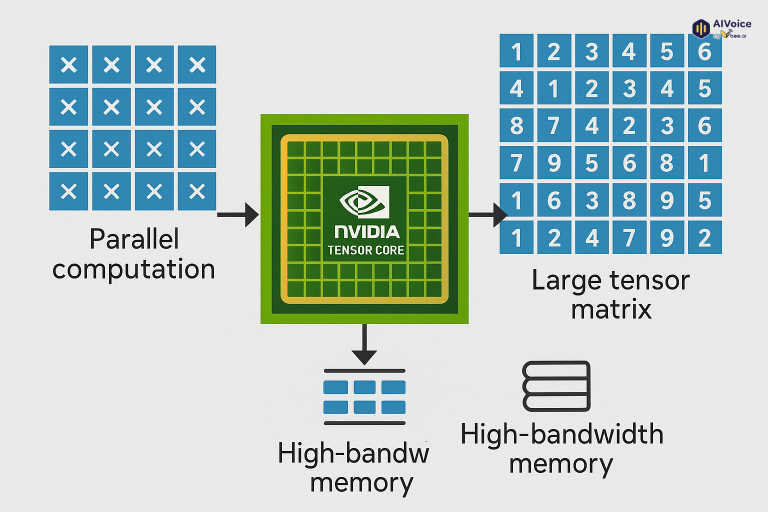

Tensor Core hoạt động bằng cách tối ưu hoá các phép toán ma trận – nền tảng của học sâu (deep learning). Cụ thể, chúng thực hiện phép nhân và cộng ma trận (Matrix Multiply and Accumulate – MAC) trong một bước duy nhất, thay vì nhiều bước như trên CUDA Core thông thường.

Điểm đặc biệt là Tensor Core sử dụng tính toán độ chính xác hỗn hợp (Mixed Precision). Ví dụ, chúng có thể nhân hai ma trận 4×4 ở định dạng 16-bit (FP16) và tích lũy kết quả ở định dạng 32-bit (FP32). Cách làm này giúp xử lý nhanh hơn, tiết kiệm bộ nhớ nhưng vẫn đảm bảo độ chính xác cho mô hình.

Nhờ thiết kế phần cứng chuyên biệt và luồng truy cập bộ nhớ hiệu quả, Tensor Core có thể tăng tốc đáng kể quá trình huấn luyện và suy luận của mạng nơ-ron, giúp mô hình AI hoạt động nhanh hơn và hiệu quả hơn nhiều lần so với khi chỉ dùng CUDA Core truyền thống.

3. Đặc điểm nổi bật của Tensor Core

Tensor Core sở hữu nhiều đặc điểm vượt trội giúp chúng trở thành công cụ không thể thiếu trong AI và Machine Learning:

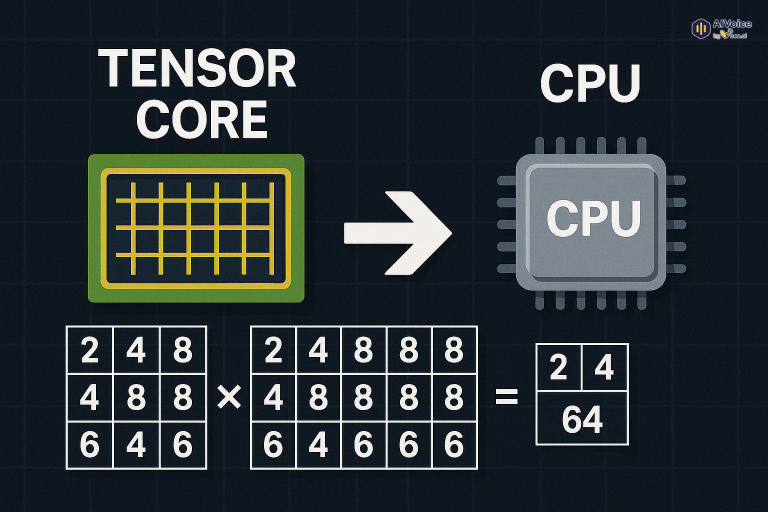

- Thực hiện các phép tính ma trận với tốc độ nhanh hơn nhiều so với CPU: Tensor Core sử dụng kiến trúc vi mạch mới được tối ưu hóa riêng cho các phép tính ma trận, khác với CPU được thiết kế cho nhiều loại tác vụ. Một Tensor Core có thể thực hiện phép nhân ma trận 4×4 chỉ trong một bước, tức là 16 phép tính trong một bước, so với chỉ một phép tính của CPU. Nhờ đó, Tensor Core có thể nhanh hơn CPU hàng chục thậm chí hàng trăm lần, đặc biệt khi xử lý các ma trận lớn.

- Tính toán trên các số dấu phẩy động với độ chính xác cao: Tensor Core có thể tính toán trên các số dấu phẩy động 16-bit và 32-bit với độ chính xác cao hơn các đơn vị xử lý truyền thống, giúp tăng tốc độ và giảm thiểu lỗi sai số. Chúng hỗ trợ đa dạng các định dạng số như FP16, FP32, INT8, INT4, FP64, TF32 và bfloat16, cho phép cân bằng giữa độ chính xác và tốc độ tính toán.

- Được thiết kế để tiết kiệm năng lượng: Tensor Core sử dụng nhiều kỹ thuật tiết kiệm năng lượng, bao gồm khả năng tự động điều chỉnh điện áp và tần số để đạt mức tiêu thụ tối ưu. Ngoài ra, việc xử lý các phép tính toán với độ chính xác thấp hơn (như FP16, INT8) cũng giúp giảm lượng dữ liệu cần xử lý và tiết kiệm năng lượng, đồng thời vẫn đảm bảo hiệu suất cao.

4. Tensor Core được dùng để làm gì?

Về cơ bản, Tensor Core giúp tăng tốc độ nhân ma trận, và các ứng dụng của chúng là vô hạn. Dưới đây là một số ứng dụng nổi bật nhất:

- Xe tự lái: Tensor Core giúp xe tự hành nhận diện người đi bộ, phương tiện và biển báo giao thông trong thời gian thực, từ đó đưa ra quyết định nhanh và chính xác khi di chuyển.

- Y tế: Tensor Core hỗ trợ phân tích hình ảnh y khoa, giúp bác sĩ phát hiện và chẩn đoán bệnh nhanh hơn, đặc biệt với các bệnh cần xử lý hình ảnh phức tạp như ung thư hoặc tổn thương nội tạng.

- Nhận diện hình ảnh và giọng nói: Nhờ khả năng xử lý dữ liệu lớn cùng lúc, Tensor Core giúp tăng tốc các hệ thống nhận diện khuôn mặt, giọng nói. Điều này rất hữu ích trong thương mại điện tử (gợi ý sản phẩm bằng hình ảnh) hay trong thiết bị điều khiển bằng giọng nói, giúp phản hồi nhanh và chính xác hơn.

5. Các thế hệ của NVIDIA Tensor Core

Tensor Core đã trải qua nhiều thế hệ phát triển, mỗi thế hệ mang lại những cải tiến đáng kể về hiệu năng và khả năng tính toán:

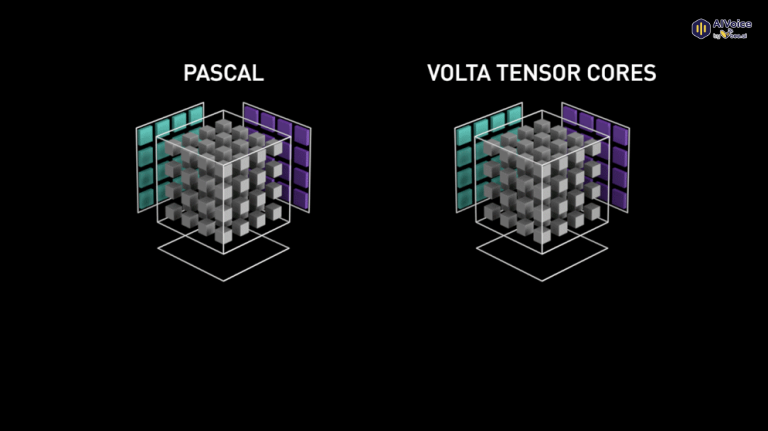

- Thế hệ 1 – Volta Tensor Core (2017)

Kiến trúc GPU Volta đánh dấu sự ra đời của Tensor Core đầu tiên, hỗ trợ đào tạo chính xác hỗn hợp bằng định dạng số FP16. Thế hệ này mang lại tiềm năng tăng thông lượng lên tới 12 lần và hiệu suất nhanh hơn 5 lần so với thế hệ GPU Pascal trước đó, với V100 hàng đầu có 640 lõi. Volta cũng được thiết kế để tiết kiệm năng lượng.

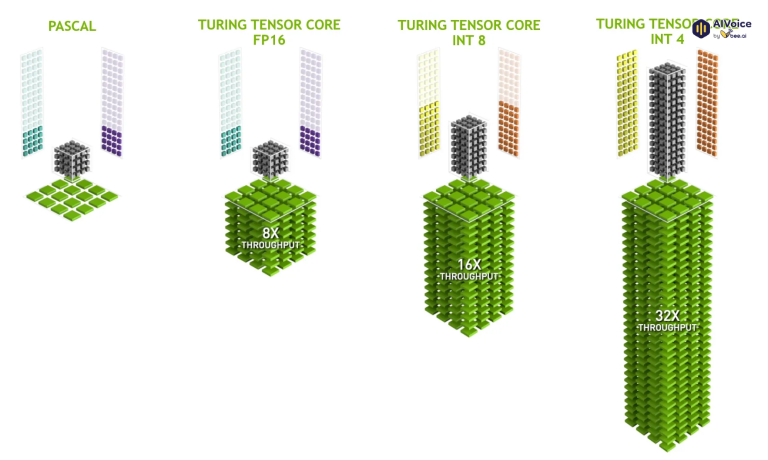

- Thế hệ 2 – Turing Tensor Core (2018)

Turing Tensor Core được giới thiệu trên kiến trúc Turing của NVIDIA, hỗ trợ thêm các độ chính xác như Int8, Int4 ngoài FP16. Chúng tăng tốc hiệu suất GPU lên tới 32 lần so với GPU Pascal và được tích hợp các lõi Ray Tracing, giúp tăng cường trực quan hóa đồ họa.

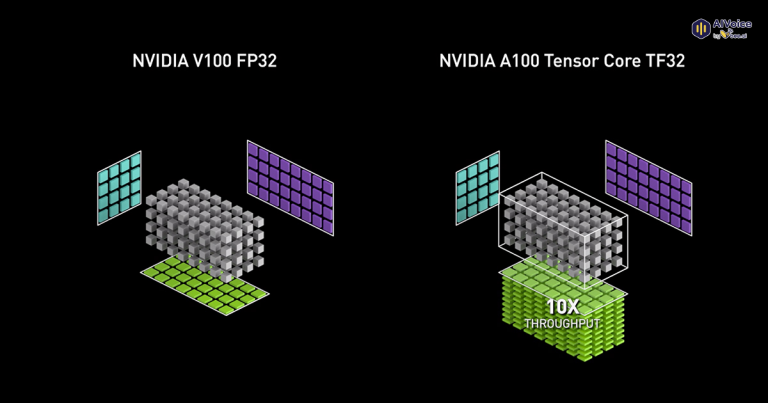

- Thế hệ 3 – A100 Tensor Core (2020)

Tensor Core thế hệ 3 trên kiến trúc Ampere mở rộng khả năng tính toán đến các độ chính xác FP64, TF32 và bfloat16, thúc đẩy hơn nữa các nhiệm vụ đào tạo và suy luận deep learning. GPU Ampere, đặc biệt là trung tâm dữ liệu A100, có các tính năng tiên tiến như chuyên môn hóa với toán học ma trận thưa thớt, NVLink thế hệ thứ ba và lõi Ray Tracing thế hệ thứ ba.

- Thế hệ 4 – H100 Tensor Core (2022)

Vi kiến trúc Hopper của NVIDIA giới thiệu thế hệ Lõi Tensor thứ tư, hỗ trợ định dạng chính xác FP8. NVIDIA tuyên bố rằng thế hệ này có thể tăng tốc các mô hình ngôn ngữ lớn lên tới 30 lần so với thế hệ trước. H100 là GPU đầu tiên có các Lõi Tensor mới này, là lựa chọn mạnh mẽ cho công nghệ deep learning mới nhất

6. So sánh điểm khác biệt của Tensor Core với CPU và GPU

Tính năng | CPU | GPU | Tensor Core |

Kiến trúc | Từng lõi thực hiện nhiều tác vụ khác nhau, tối ưu cho tác vụ tuần tự. | Nhiều lõi đơn giản, tối ưu cho các tác vụ song song đơn giản. | Kiến trúc chuyên dụng, tối ưu hóa cho các phép tính ma trận. |

Mục đích sử dụng | Xử lý các tác vụ đa nhiệm, ứng dụng văn phòng, hệ điều hành,…. | Xử lý đồ họa, tính toán khoa học, học máy,…. | Tăng tốc các thuật toán học sâu, đặc biệt là các phép tính ma trận. |

Hiệu năng | Tốt ở các tác vụ tuần tự, kém hơn GPU và Tensor Core trong các tác vụ tính toán song song. | Rất tốt ở các tác vụ tính toán song song đơn giản, nhưng kém hiệu quả hơn Tensor Core trong các phép tính ma trận. | Xuất sắc trong các phép tính ma trận, là công cụ lý tưởng cho học sâu. |

Độ phức tạp của tác vụ | Có thể xử lý các tác vụ phức tạp và đa dạng. | Thường được sử dụng cho các tác vụ đơn giản, lặp đi lặp lại. | Chuyên biệt cho các phép tính ma trận, không phù hợp với các tác vụ khác. |

7. Các câu hỏi thường gặp về Tensor Core

7.1 Tensor Core có trên tất cả các GPU của NVIDIA không?

Không. Tensor Core chủ yếu xuất hiện trên các GPU cao cấp và trung tâm dữ liệu của NVIDIA như dòng Volta, Turing, Ampere (A100), Hopper (H100). Một số GPU dòng consumer như GeForce RTX cũng có tích hợp Tensor Core, nhưng không phải tất cả GPU NVIDIA đều có.

7.2 Tensor Core có dùng để chơi game được không?

Có. Tensor Core hỗ trợ công nghệ DLSS (Deep Learning Super Sampling) giúp nâng cấp hình ảnh mà vẫn giữ hiệu suất cao. Ngoài ra, chúng cũng hỗ trợ Ray Tracing trong các tựa game hiện đại.

7.3 Tensor Core khác gì so với CUDA Core?

CUDA Core xử lý các phép toán thông thường trong GPU, còn Tensor Core được tối ưu riêng cho các phép tính ma trận trong AI/ML. Tensor Core có thể thực hiện hàng trăm phép tính cùng lúc trên các khối dữ liệu lớn, vượt trội về hiệu năng trong lĩnh vực deep learning.

7.4 Tôi có thể sử dụng Tensor Core để học máy cá nhân không?

Có, nếu bạn sử dụng các GPU như NVIDIA RTX 30/40 series hoặc A100 trên đám mây. Bạn có thể tận dụng Tensor Core thông qua các framework như TensorFlow hoặc PyTorch để tăng tốc huấn luyện và suy luận mô hình.

7.5 Tensor Core có hỗ trợ tính toán chính xác cao không?

Có. Các thế hệ Tensor Core mới hỗ trợ nhiều định dạng số khác nhau như FP16, TF32, bfloat16, FP8 và cả FP64 (double precision), giúp cân bằng giữa hiệu suất và độ chính xác.

7.6 Có thể tiết kiệm điện năng khi sử dụng Tensor Core không?

Có. Nhờ khả năng xử lý dữ liệu hiệu quả và hỗ trợ định dạng số thấp (như FP8, INT8), Tensor Core giúp giảm điện năng tiêu thụ so với CPU hoặc GPU truyền thống khi thực hiện tác vụ tương tự.

Hy vọng với những thông tin trên, bạn đọc có thể hiểu thêm về Tensor Core, không chỉ là một thành phần phần cứng đơn thuần, mà là nền tảng thúc đẩy những bước tiến vượt bậc trong AI, từ nhận diện hình ảnh, xử lý ngôn ngữ đến xe tự lái và y học thông minh. Trong tương lai, khi các mô hình AI ngày càng phức tạp và dữ liệu ngày càng lớn, vai trò của Tensor Core sẽ càng trở nên quan trọng hơn bao giờ hết.